Anuncio

Si tienes las habilidades mentales, un talento para la programación y la narración de historias, y un buen ojo para el diseño, puedes hacer algo peor que entrar en la ciencia de datos. Es la gran novedad en tecnología; altamente moderno y bien pagado, con científicos de datos buscados por algunas de las compañías más grandes del mundo.

ScraperWiki es una empresa que se ha asociado durante mucho tiempo con el campo de la ciencia de datos Durante los últimos años, esta startup con sede en Liverpool ha ofrecido una plataforma para que los codificadores escriban herramientas que obtengan datos, los limpien y los analicen en la nube.

Con una actualización reciente y la creciente demanda de científicos de datos en la empresa, vale la pena echar un vistazo a ScraperWiki.

Divulgación completa: fui pasante en ScraperWiki el verano pasado.

¿Qué hace ScraperWiki?

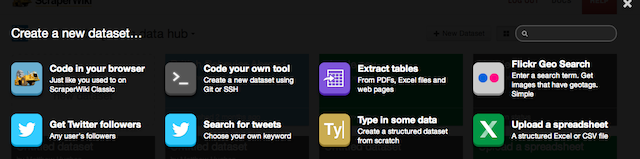

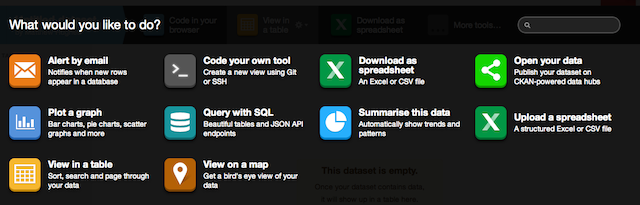

ScraperWiki se comercializa como un lugar para obtener, limpiar y analizar datos, y cumple con cada uno de esos conteos. En su forma más simple, le permite a usted, el usuario, un lugar donde puede escribir código que recupere datos de una fuente, herramientas para convertir en un formato fácil de analizar y almacenamiento para guardarlo para su posterior visualización, que también puede manejar con ScraperWiki.

También viene con una serie de herramientas preconstruidas que automatizan tareas repetitivas, que incluyen obtener datos de archivos PDF, que son notoriamente difíciles de decodificar. Esto es adicional a Búsqueda en Twitter 5 trucos geniales de búsqueda en Twitter para monitorear lo que la gente dice sobre tiSi posee un sitio web o simplemente está tratando de ganar dinero en línea como profesional independiente, siempre es bueno saber qué dice la gente sobre usted a través de Internet. La gente puede estar citando ... Lee mas y raspar utilidades. No necesita ninguna experiencia en desarrollo de software para usarlos.

Costo

Como se mencionó anteriormente, ScraperWiki adopta el modelo de precios freemium y ofrece un servicio que tiene múltiples niveles. Aquellos que recién comienzan con la ciencia de datos o con necesidades limitadas pueden hacer uso del servicio gratuito. Esto le brinda tres conjuntos de datos, donde almacena sus datos y código.

Aquellos que planean escribir múltiples raspadores o que desean hacer montañas de análisis de datos pueden desembolsar algo de dinero en efectivo para una cuenta premium. Estos comienzan en $ 9 por mes y ofrecen 10 conjuntos de datos. Si eso aún no es suficiente, siempre puede actualizar a su nivel más alto que viene con 100 conjuntos de datos y cuesta $ 29 por mes.

Codificación

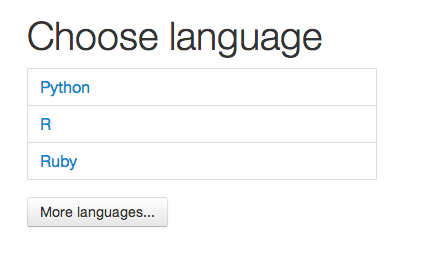

Los programadores son a menudo bastante particulares cuando se trata de cómo codifican. Algunos prefieren los lenguajes de secuencias de comandos a los lenguajes compilados. Algunos prefieren la experiencia reducida de un editor de texto sobre la de un entorno de desarrollo integrado (IDE). ScraperWiki lo reconoce y le da al usuario una gran cantidad de opciones cuando se trata de cómo escribir su código.

Si está tan inclinado, puede escribir su código en el navegador. Como es de esperar de cualquier profesional, basado en la web Los 3 mejores IDE basados en navegador para codificar en la nube Lee mas herramienta de desarrollo, esta viene con características que cualquier programador consideraría esencial, como el resaltado de sintaxis.

Se ofrecen varios idiomas. Éstas incluyen Pitón Los 5 mejores sitios web para aprender programación de Python¿Quieres aprender programación de Python? Estas son las mejores formas de aprender Python en línea, muchas de las cuales son completamente gratuitas. Lee mas , un lenguaje de scripting popular utilizado por personas como Google y NASA; Rubí 3 formas interactivas, divertidas y gratuitas de comenzar a aprender el lenguaje de programación RubyRuby es un lenguaje expresivo de scripting de muy alto nivel. Se utiliza en la Web principalmente como parte del marco de desarrollo web de Ruby on Rails, pero también es independiente. Si tienes curiosidad por saber qué es Ruby (no ... Lee mas , que impulsa varios sitios web populares como Living Social; y el popular lenguaje de análisis estadístico, R.

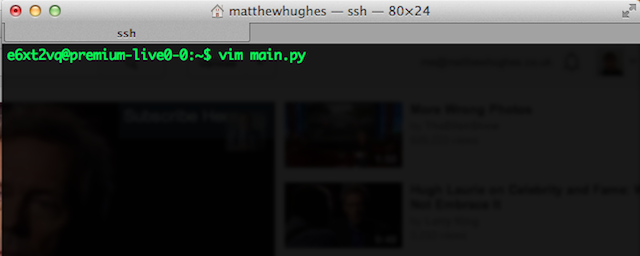

Además, también puede escribir código desde la línea de comandos utilizando SSH, Git y cualquier editor de texto que le guste. Sí, lo leiste bien. SSH Qué es SSH y en qué se diferencia de FTP [Tecnología explicada] Lee mas . Cada cuadro que usa es su propia cuenta de Linux, y puede conectarse a él como lo haría con un VPS o cualquier otra cuenta de shell. Hay varios editores de texto disponibles, incluidos Empuje Las 7 razones principales para darle una oportunidad al editor de texto VimDurante años, probé un editor de texto tras otro. Lo que sea, lo probé. Utilicé a todos y cada uno de estos editores durante más de dos meses como mi principal editor diario. De alguna manera, yo ... Lee mas que se puede ampliar con complementos y editando la configuración. Aquellos intimidados por Vim pueden usar Nano, que es un editor de texto de línea de comandos liviano.

Las bibliotecas instaladas deberían ser suficientes para escribir herramientas para recuperar datos y procesarlos. Si necesita algo un poco más oscuro, siempre puede crear un virtualenv desde la línea de comandos. Como puede ver, existe una gran flexibilidad para los desarrolladores.

Visualización de datos

Entonces, tienes tus datos. Lo has normalizado. Lo has limpiado. Lo has analizado. Ahora es el momento de hacer un poco de visualización y mostrarle al mundo lo que has aprendido.

ScraperWiki permite a los desarrolladores mostrar sus datos utilizando páginas web construidas a partir de la trifecta familiar de HTML, CSS y JavaScript. Además, los componentes de Bootstrap son compatibles desde el primer momento.

Hay una serie de visualizaciones prefabricadas disponibles, incluidas las que trazan sus datos en un mapa y encuentran tendencias dentro de sus hallazgos. Para usarlos, debe asegurarse de que sus datos estén almacenados como un archivo SQLite con el nombre de archivo "scraperwiki.sqlite". Luego simplemente agrega la visualización que le interesa. Simple, ¿verdad?

Conclusión

ScraperWiki ofrece mucho a los desarrolladores que desean hacer un análisis de datos sin que su entorno de desarrollo se interponga en su camino, a la vez que tienen la flexibilidad de complacer incluso a los usuarios más exigentes. Pero ¿qué piensas? Déjame saber abajo en los comentarios.

Autor de la foto: Ciencia espacial (Dan Brown)

Matthew Hughes es un desarrollador y escritor de software de Liverpool, Inglaterra. Raramente se lo encuentra sin una taza de café negro fuerte en la mano y adora absolutamente su Macbook Pro y su cámara. Puedes leer su blog en http://www.matthewhughes.co.uk y síguelo en twitter en @matthewhughes.